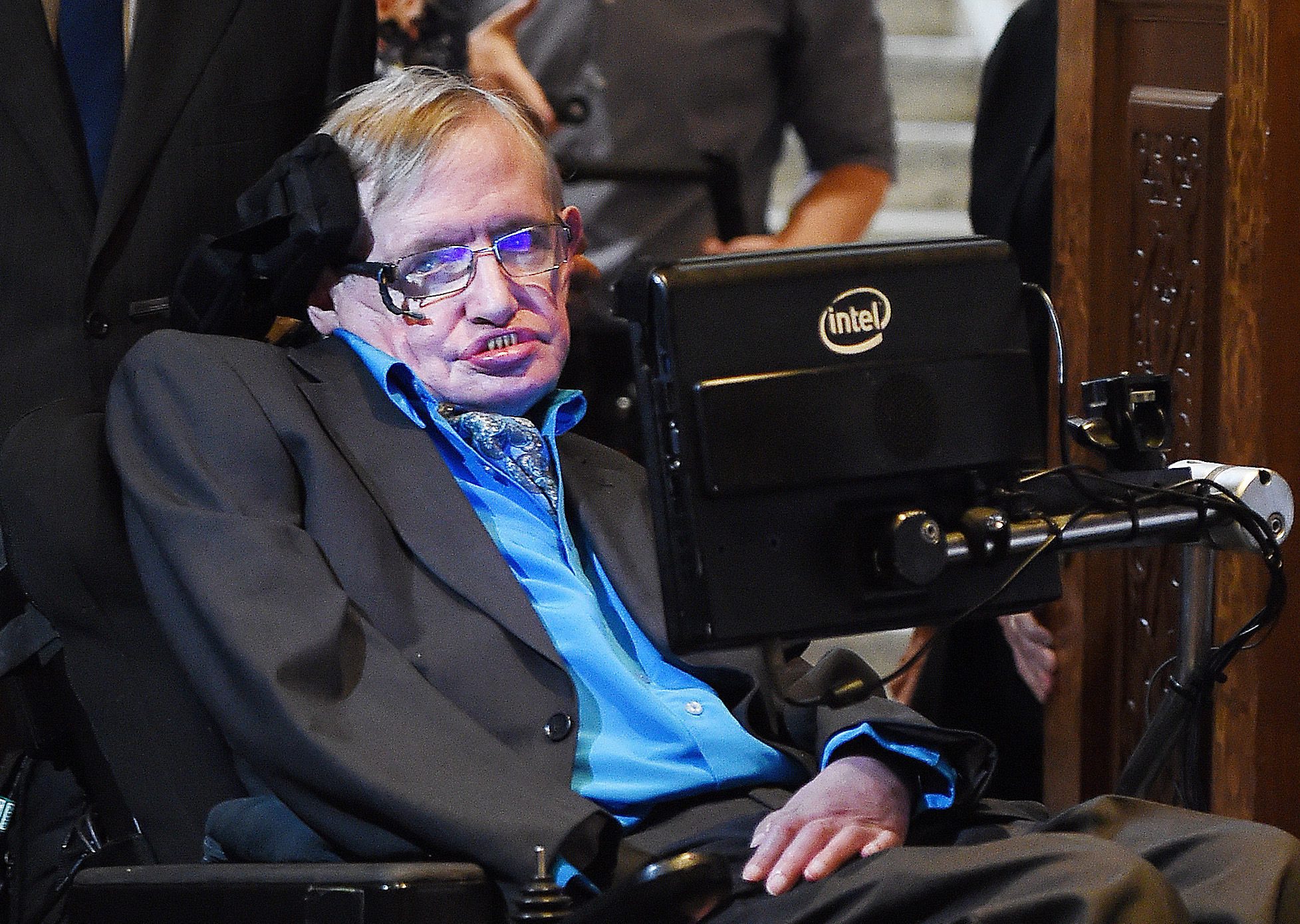

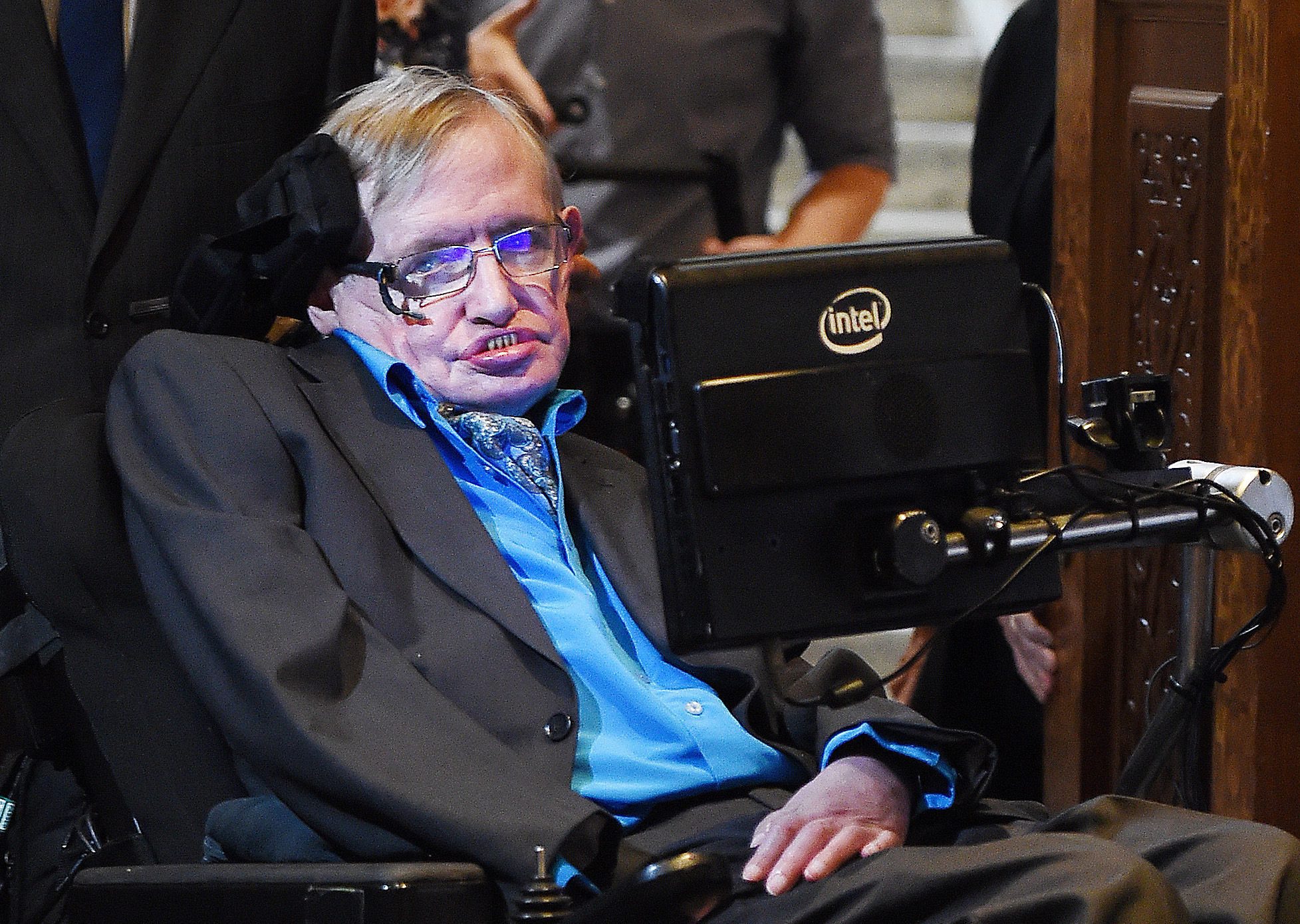

Стивън Хокинг: Да внимаваме с корпорациите

Контролът върху изкуствения интелект от страна на корпорациите може да обрече останалите слоеве от обществото на нищета, предупреждава Стивън Хокинг.

Британският физик засегна темата за технологичната безработица – ситуация, при която технологичните промени водят до спад в търсенето на работна сила.

В бъдеще основната част от производството може да бъде напълно автоматизирана и изпълнявана от роботи.

Стив Возняк: Хората изгубиха битката с машините >> >> >>

Възможни са два сценария на развитие.

При първия ще се подобри животът на всички хора за сметка на труда на машините.

Във втория сценарий обаче собствениците на корпорации, които контролират създаването на умни системи и роботи, ще застанат на върха на света, докато останалите слоеве от обществото ще потънат в нищета.

Отчитайки сегашната ситуация, Стивън Хокинг прави извода, че човечеството по-скоро се развива по втория сценарий.

Задават се войници-роботи с изкуствен интелект >> >> >>

Хокинг отново говори и за опасностите на изкуствения интелект като цяло.

По неговите думи, заплахата от изкуствения интелект в момента се състои не в това, че той е лошо нещо, а в това, че е компетентен. Суперинтелигентният разум ще бъде изключително ефективен при постигане на своите цели и ако те не съвпадат с тези на хората, човечеството ще се окаже в беда.

Хокинг и експерти: Забрана на AI за военни цели >> >> >>

Ученият дава за пример мравуняк, който се оказва в зоната на наводняване при строителство на водно-електрическа централа. В този случай хората не са преднамерени и зли унищожители на мравките, но при реализация на проекта едва ли ще се замислят за тях.

Същата ситуация може да възникне и с изкуствения интелект, ако хората му пречат при изпълнение на дадена задача.

Да не поставяме човечеството в положението на мравките, казва Стивън Хокинг, цитиран от Reddit.

Хокинг: Трябва да намерим убежище извън Земята >> >> >>

Друга заплаха от страна на изкуствения разум може да се окаже това, че за изпълнение на поставените цели, ИИ отнема от човека жизнено-важни ресурси, например енергия.

Водещият физик не се ангажира с възможни срокове за създаване на пълноценен изкуствен интелект, но според него, когато се появи подобен разум, това ще бъде или най-доброто, или най-лошото изобретение на човечеството.