15 ключови риска на изкуствените интелекти

Сред тях са етични дилеми, проблеми със сигурността, концентрация на властта, зависимост от ИИ, загуба на работни места, отслабване на връзките между хората, екзистенциални заплахи за човечеството и др.

Общото събрание на ООН одобри първата си глобална резолюция за изкуствения интелект (ИИ), която цели да гарантира, че технологията е "безопасна, сигурна и надеждна". Резолюцията цели да насърчи защитата на личните данни, следенето на ИИ за рискове и опазването на човешките права, заявиха представители на ООН, цитирани от БТА.

Но пред какви рискове точно изкуствените интелекти изправят човечеството? В свой анализ сп. "Форбс" изброява 15 ключови риска.

Те са липса на прозрачност, дискриминация, защита на личните данни, етични дилеми, проблеми със сигурността, концентрация на властта, зависимост от ИИ, загуба на работни места, засилване на икономическото неравенство, правни проблеми, надпревара във въоръжаването, (още по-голямо) отслабване на връзките между хората, манипулация и дезинформация, неочаквано поведение и екзистенциални заплахи за човечеството.

Проучване на Станфорд добавя към това опасността от прекомерно разчитане на технологични решения и рискове при използването на ИИ за медицински цели - особено ако ИИ е обучаван въз основа на данни, събрани от друга етническа група.

Да разгледаме някои от тях.

Липсата на прозрачност пречи на хората да разбират как ИИ стига до заключенията си. Това, от своя страна, води до недоверие.

От друга страна, дискриминацията и предубежденията са свързани с данните, върху които са се обучавали. В зависимост от тях (и начина на работа на алгоритмите им), изкуствените интелекти може да разпространяват определени предубеждения, отбелязва "Форбс".

Това е още по-опасно, ако всички ги смятат за "непредубедени машини".

Нарушения на правото на защита на личните данни и защитата на личния живот са една от водещите теми, защото технологиите, свързани с ИИ, често се базират на събиране и анализиране на големи количества данни - в които може да са били включени и лични данни. Срещу тази заплаха е насочена и последната резолюция на Общото събрание на ООН.

От друга страна, ИИ може да води и до социални промени. Това е нов инструмент, а както ни е показала историята, появата на нов инструмент води до социални промени - независимо дали говорим за производството на бронз в бронзовата епоха, използването на стоманата, огнестрелните оръжия, парната машина, двигателите с вътрешно горене, атомната енергия, компютрите...

Концентрирането на ИИ в ръцете на определени, богати личности, корпорации и правителства, може да доведе до концентрация на властта в техни ръце. В същото време ИИ може да засегне нископлатените работни места според доклада на "Маккинзи", който предвижда, че те ще бъдат 14 пъти по-засегнати.

Заплашени са обаче и по-високоплатени позиции. ОИСР предупреди още миналата година, че финансовият и правният сектори може да се окажат сред най-тежко засегнатите, отбелязва британският в. "Гардиън".

Всичко това очевидно би могло да доведе до нарастващи различия в доходите и намаляване на възможностите за социална мобилност. Особено, ако технологията не се използва отговорно, или с мисъл за бъдещето: проучване на "Харвард Бизнес Ривю" предупреждава, че "компаниите, които заменят хората с ИИ, ще бъдат изпреварени от конкуренцията".

Но всичко това се отнасяше до законното използване на изкуствени интелекти. А какво става, когато попадне в ръцете на хора, които не се съобразяват със закона, имат различен морал от общоприетия, и не се интересуват от общественото мнение?

Тогава изкуствените интелекти може да увеличат и направят по-големи заплахите за сигурността, независимо дали тези заплахи са водени от престъпни, религиозни, идеологически или политически мотиви. Във всички случаи дезинформацията чрез "дълбоки фалшификати" е далеч по-лесна с помощта на ИИ. ИИ, който може да води разговор с вас, вероятно може и да ви се обади по телефона... и може би - да ви съобщи, че ваш близък е бил блъснат от кола и трябва да дадете едни пари за операцията, спешно е...

Но дори без възможността да говори, машините пак могат да водят диалог с вас, примерно в социалните мрежи. Чатботовете не са от вчера! Но досега бяха лесни за забелязване, защото допускаха смешни грешки. Но ако бъдат включени към ИИ?

Представете си ИИ, което е обучено да действа като интернет трол, подкрепящо определена политическа кауза. То няма нужда от почивка, генерира си картинките само, поддържа без усилие множество профили, няма причини да няма и множество "приятели"... между другото, давали ли сте "приятелство" на някого в социалните мрежи? Ако да - сигурни ли сте, че е човек?

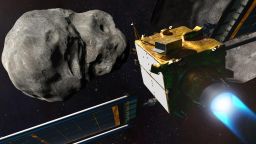

Още по-голяма заплаха е разработването на автономни, смъртоносни оръжия, които могат сами да избират целите си. Както отбелязва проучване на Станфордския университет, десетки страни използват от десетилетия ограничени варианти на тези модели, например при защитата на военни и военноморски бази.

Но - ограничени. Какво ще могат да правят "интелигентните боеприпаси на бъдещето" и дали ще бъдат използвани, за да поразяват целите си по-избирателно, или само по-ефективно?

А какви възможности ни предлага новата технология?

"Изкуственият интелект предоставя и значителни универсални възможности за ускоряване на борбата с бедността, спасяване на човешки животи и защита на нашата планета", подчерта постоянната представителка на САЩ в ООН Линда Томас-Грийнфийлд, като напомни за ползите, които според нея вече се наблюдават в медицинската диагностика и селското стопанство.